Если вы работаете с корпоративным сайтом, особенно в сфере электронной коммерции, вы, вероятно, используете какую-то фасетную (пересекающуюся по разным признакам) структуру навигации. А почему бы нет? Это позволяет пользователям без проблем фильтровать результаты по цвету или ценовому диапазону. Но то, что так полезно для пользователей, может стать настоящим кошмаром для SEO. Множество комбинаций адресов, живых и индексируемых, имеют дублированный контент. Эти дубли затрудняют для поисковых систем обнаружение обновлений контента, что, соответственно, негативно влияет на индексацию. Не будем сейчас рассматривать в подробностях, что такое фасетная навигация, и почему она является проблемой для поисковиков. Сузим эту проблему до одного простого вопроса и сосредоточимся на его возможных решениях. Мы должны ответить на вопрос: “Как помочь веб-мастерам сделать фасетную навигацию дружелюбной для поиска Google?”.

Краткий обзор фасетной навигации

Фасетную навигацию мы можем определить как любой способ фильтрации и (или) сортировки результатов на веб-странице с помощью ряда признаков, которые не обязательно будут связаны между собой. Например: цвет, тип процессора и разрешение экрана ноутбука. Вот образец:

Поскольку каждая возможная комбинация характеристик обычно имеет по крайней мере один уникальный URL-адрес, фасетная навигация может создать несколько проблем для SEO:

- Она создает много дублированного контента, что плохо по целому ряду причин.

- Она размывает ссылочную массу и отправляет поисковых роботов на страницы, которые нам даже не нужно индексировать.

- Она может отправлять неправильные сигналы Google и создавать лишнюю и бесполезную нагрузку в пропускной способности сайта.

Несколько примеров

Стоит потратить пару минут своего времени, чтобы ознакомиться с несколькими примерами фасетной навигации, которые, вероятно, приносят вред SEO. Данные примеры наглядно иллюстрируют, как фасетная навигация может быть недружелюбной в отношении поиска.

Macy’s

К поиску домена добавляем “черные платья” в качестве ключевого слова, чтобы посмотреть, какие результаты будут отображаться. В момент создания этого текста существовал 991 товар, подходящий под “черные платья”, так почему же по этому ключевому слову проиндексировано более 12000 страниц? Ответ может быть скрыт в настройках фасетной навигации. Как оптимизаторы, мы можем исправить эту проблему.

Home Depot

Давайте возьмем Home Depot в качестве еще одного примера. Снова мы находим 8 930 страниц. Есть ли причина, по которой страниц в индексе, ориентированном на аналогичные продукты так много? Возможно нет. Хорошей новостью является то, что это можно исправить с помощью правильных комбинаций тегов (которые мы рассмотрим ниже).

Пока что примеров достаточно. Вы можете перейти на большинство широкомасштабных веб-сайтов электронной коммерции и обнаружить проблемы с их навигацией. Дело в том, что многие крупные веб-сайты, использующие фасетную навигацию, могут улучшить свои результаты в SEO.

Решения в фасетной навигации

При выборе фасетной навигации вам нужно будет решить, что вы хотите увидеть в индексе, и как это можно реализовать. Давайте посмотрим, о каких вариантах реализации может идти речь.

«Noindex, follow»

Вероятно, первое решение, которое приходит в голову, это использование меток noindex. Тег noindex нужен нам с одной-единственной целью — дать ботам знать, что определенная страница не должна индексироваться. Итак, если бы мы просто хотели удалить страницы из индекса, такое решение было бы целесообразным.

Проблема заключается в том, что, хотя у вас и выйдет значительно уменьшить количество дублированного контента, вы все еще будете тратить поисковый бюджет на обход страниц. Кроме того, эти страницы получат ненужную ссылку, не приносящую никакой пользы.

Пример: Если бы мы хотели индексировать страницу для “черных платьев”, но при этом не хотели бы показывать “черные платья по цене ниже 100 долларов”, добавление тега noindex к последнему варианту решало бы проблему. Тем не менее, хотя трудозатраты поисковых роботов и уменьшаются, на эти страницы они все равно попадают.

Канонизация

Многие сайты подходят к решению проблемы с помощью канонических тегов. Таким образом, можно сообщить Google, что среди массы похожих страниц у вас есть предпочтительная версия. Поскольку канонические теги были разработаны именно в качестве решения проблемы дублированного контента, вариант их использования кажется вполне разумным. Кроме того, ссылка будет закреплена на той странице, которую вы считаете приоритетной. Однако, Google по-прежнему будет сканировать все страницы.

Пример: /black-dresses?Under-100/ будет иметь канонический URL, установленный в /black-dresses/. В этом случае Google отдаст основной странице приоритет и предоставит ссылочную маржу. Помимо этого, он не увидит страницу “?Under-100” как дубликат основной версии.

Отключить с помощью robots.txt

Запретить к сканированию разделы сайта (например, определенные параметры) может оказаться отличным решением. Осуществить такие настройки можно быстро и легко. Но и здесь таятся некоторые недостатки. Даже если вы сообщите Google о запрете посещения определенной страницы (или целого раздела) на вашем сайте, он все равно может его проиндексировать.

Пример: мы можем запретить *?Under-100* в нашем файле robots.txt. Это отдаст команду поисковым роботам Google не посещать любую страницу с этим параметром. Однако, если бы существовали какие—либо «follow» ссылки, указывающие на любой URL с этим параметром, Google все равно мог бы его индексировать.

«Nofollow» внутренние ссылки на нежелательные страницы

Пометив все лишние для сканирования URL-адреса атрибутом rel=»nofollow», вы сократите трудозатраты поисковика и предотвратите снижение частоты сканирования, но, к сожалению, все еще не сможете устранить проблему глобально. Повторяющийся контент все еще может быть проиндексирован.

Пример: Если мы не хотим, чтобы роботы Google посещали страницы, на которых пересекаются два и более признаков, добавляя тег nofollow ко всем внутренним ссылкам, вы достигнете желаемого результата.

Как избежать проблемы в глобальном масштабе

Очевидно, если бы могли избежать проблемы в целом, это было бы сделано. Если в настоящее время вы создаете свой веб-сайт или занимаетесь перестройкой навигации на нем, хотелось бы настоятельно рекомендовать вам рассмотреть возможность создания фасетной навигации таким образом, чтобы ограничивать изменяемый URL-адрес (обычно это делается с помощью JavaScript). Причина проста: так обеспечивается простота просмотра и фильтрации товаров, а потенциально генерируется только один URL-адрес. Однако, это может далеко завести вас в противоположном направлении — придется вручную убеждаться, что у вас присутствуют индексируемые целевые страницы для ключевых комбинаций.

Каково же идеальное решение?

Во-первых, важно понимать, что не существует «идеального универсального решения». Для создания оптимальной реализации фасетной навигации вам, скорее всего, понадобится использовать комбинацию описанных выше опций. Ниже мы рассмотрим пример, который должен работать для большинства сайтов, но важно понимать, что ваше индивидуальное решение может иметь свои отличия в зависимости от принципов построения сайта и того, как структурированы ваши URL-адреса и другие факторы.

Подумайте о следующем: у вас имеется веб-сайт с фасетной навигацией, который позволяет обнаруживать и индексировать каждую комбинацию признаков и параметров. Вы не беспокоитесь о достоверности ссылок, но Google явно тратит драгоценное время на сканирование миллионов страниц, в просматривании которых вы вообще не заинтересованы. Рассмотрим конкретный сценарий, в котором мы позаботимся об экономии поискового бюджета.

В этом сценарии рекомендованы следующие этапы:

- Страницы разделов, категорий и подкатегорий должны оставаться открытыми для индексации. (Например, /clothing/, /clothing/womens/, /clothing/womens/ dresses/).

- Для каждой страницы категорий разрешается индексировать версию только с 1 признаком.

- На страницах, где выбран 1 или несколько параметров, все ссылки на них становятся ссылками nofollow (например, /clothing/womens/ dresses?Color = black/).

- На страницах, где выбраны два и более параметров, добавляется также тег «noindex» (например, /clothing/womens/ dresses?Color=black?Brand=express?/)

- Определите, какие параметры могут иметь SEO преимущество (например, «цвет» и «бренд») и присвойте им белый список. По сути, бросьте их обратно в индекс для целей SEO.

- Убедитесь, что ваши канонические теги и rel = prev / next теги настроены соответствующим образом.

Это решение (со временем) начнет приносить свои плоды — решать существующие проблемы с ненужными страницами, попавшими под индексацию из-за особенностей навигации сайта. Обратите внимание, как в этом сценарии использован комплексный подход — комбинация нескольких возможных решений. Для достижения результата используется «nofollow», «noindex, nofollow» и правильная канонизация.

Другие вещи, которые можно принять во внимание

Есть много других переменных, которые следует рассмотреть в этой теме. Уделим внимание двум наиболее важным.

“Хлебные крошки” (и разметка) очень помогают

Если у вас нет “хлебных крошек” (навигационной цепочки) на каждой странице категорий и подкатегорий, вы оказали себе медвежью услугу. Пожалуйста, займитесь их реализацией. Если же хлебные крошки у вас имеются, но вы не маркируете их микроданными, вы тоже теряете огромные преимущества.

Причина проста: на вашем сайте сложная навигация, и роботы, посещающие ваш сайт, вполне возможно, неправильно трактуют иерархию. Добавляя точное дублирующее меню, мы отправляем Google эффективное сообщение: “Эй, я знаю, что навигация сбивает с толку, но, пожалуйста, рассмотрите возможность сканирования нашего сайта вот таким образом”.

Обеспечение URL-адреса для комбинаций параметров

Иногда вы можете встретить сайт с уникальными URL-адресами для каждой комбинации параметров. Например, если вы находитесь на странице ноутбука и выбираете в фильтрах “красный” и “SSD” (в этом порядке), то URL-адрес может быть /laptops?color=red?SSD/. Теперь представьте, если бы вы выставили фильтры в обратном порядке (сперва «SSD», затем «красный»), то сгенерированный URL-адрес выглядел бы так — /laptops?SSD?Color=red/.

Это действительно плохо, потому что экспоненциально увеличивает количество имеющихся URL-адресов. Избегайте таких ситуаций, применяя определенный порядок для URL-адресов.

Выводы

Надеемся, вы станете чувствовать себя увереннее и подготовленнее в вопросах управления фасетной навигацией, а также у вас появятся новые идеи, как принести пользу вашему поисковому присутствию.

Итак, подведем итоги и сделаем основные выводы:

- Фасетная навигация может быть полезной для пользователей, но обычно ее настройка негативно влияет на SEO.

- Существует много причин, по которым фасетная навигация может навредить SEO, но в тройку основных входят следующие:

- Дублированный контент.

- Напрасная трата бюджета сканирования.

- Неэффективное использование ссылочной массы.

- Следующий вопрос, на который мы хотим получить ответ звучит так: “Каким образом мы можем контролировать то, что Google сканирует и индексирует?”

- Не существует универсального решения для всех сайтов. Но есть много вариантов, которые можно использовать. Чаще всего в ход идут такие:

- Noindex.

- Канонизация.

- Robots.txt.

- Nofollow для нежелательных параметров.

- Решение проблемы с помощью AJAX/JavaScript.

В комментариях к статье вы можете рассказать о собственном опыте решения проблем фасетной навигации. Какие потенциальные проблемы навигации вам удалось выявить и какие решения оказались для вас наиболее эффективными?

Источник: https://moz.com/blog/large-site-seo-basics-faceted-navigation

(3 оценок, среднее: 3,67 из 5)

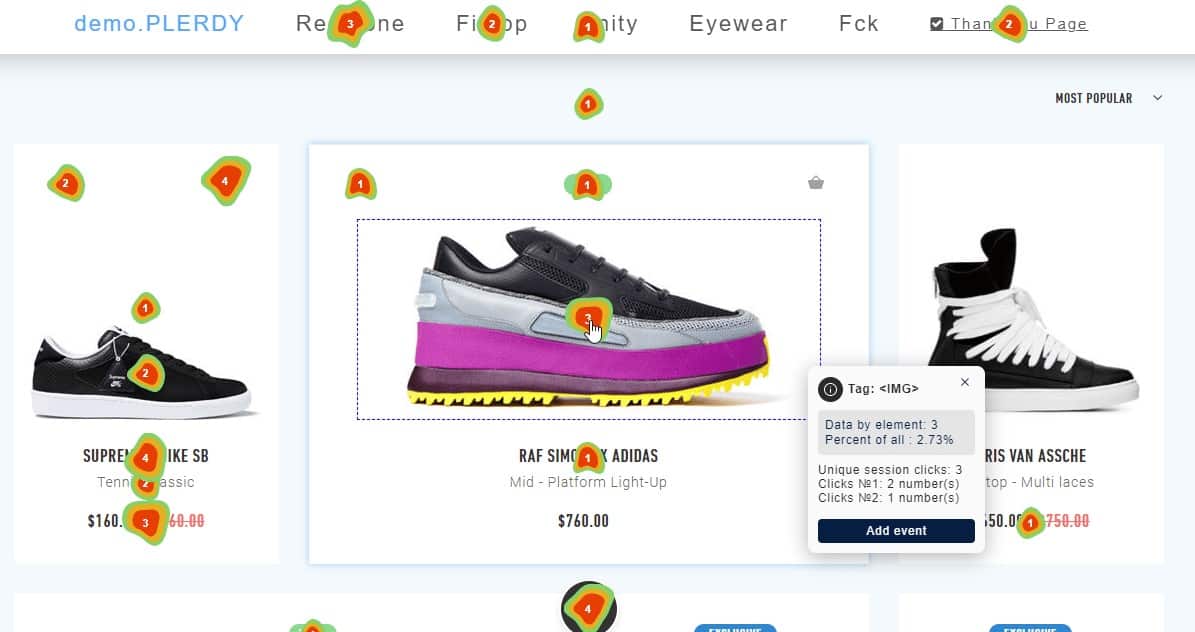

(3 оценок, среднее: 3,67 из 5) Карта кликов сайта: обзор 16 сервисов

Карта кликов сайта: обзор 16 сервисов Продвижение сайтов

Продвижение сайтов Бесплатная раскрутка сайта в Google: 20 советов

Бесплатная раскрутка сайта в Google: 20 советов Продвижение интернет-магазина

Продвижение интернет-магазина Продвижение сайта в ТОП-10 Google

Продвижение сайта в ТОП-10 Google Контекстная реклама сайта в Google: 27 ошибок

Контекстная реклама сайта в Google: 27 ошибок SEO для малого бизнеса: ответы, которые Вы ищете

SEO для малого бизнеса: ответы, которые Вы ищете Юзабилити аудит сайта

Юзабилити аудит сайта SEO продвижение сайтов

SEO продвижение сайтов SEO оптимизация интернет магазина

SEO оптимизация интернет магазина