Аналітик Google Джон Мюллер на останній зустрічі з вебмайстрами відповів про те, як пошуковик ставиться до «величезних» та «складних» файлів robots.txt.

Йшлося про файл, де є 1500 рядків та безліч директив disallow, кількість яких з роками збільшувалася.

За словами Мюллера, великий файл robots.txt безпосередньо не впливає на пошукову оптимізацію сайту. Проте його складно підтримувати, а це може спричинити непередбачені проблеми.

На питання: Чи можливі проблеми, якщо не включати Sitemap у robots.txt?

Мюллер відповів наступне: “Ні, для нас ці різні способи відправки Sitemap є еквівалентними“.

Мюллер відповів і на інші питання на цю тему:

«Якщо радикально скоротити файл robots.txt, як це позначиться на SEO? Наприклад, видалити всі директиви disallow?» (У такому випадку директивою disallow закриті елементи футера та хедера сторінок, які не становлять інтересу для користувачів.)

За словами Мюллера, важко сказати, що відбудеться, коли ці фрагменти почнуть індексуватися. Найкраще рішення – використання підходу «проб і помилок». Наприклад, можна відкрити для сканування один з цих фрагментів і подивитися, що відбуватиметься в пошуку, щоб зрозуміти, чи це проблема.

Мюллер зазначив, що в robots.txt дуже просто щось заблокувати, але для підтримки об’ємних файлів потім знадобиться багато часу, тому важливо зрозуміти, чи ці блокування дійсно потрібні.

Конкретних рекомендацій у Google немає щодо розміру. В одних сайтів ці файли великі, в інших – маленькі. Головне, щоби вони працювали.

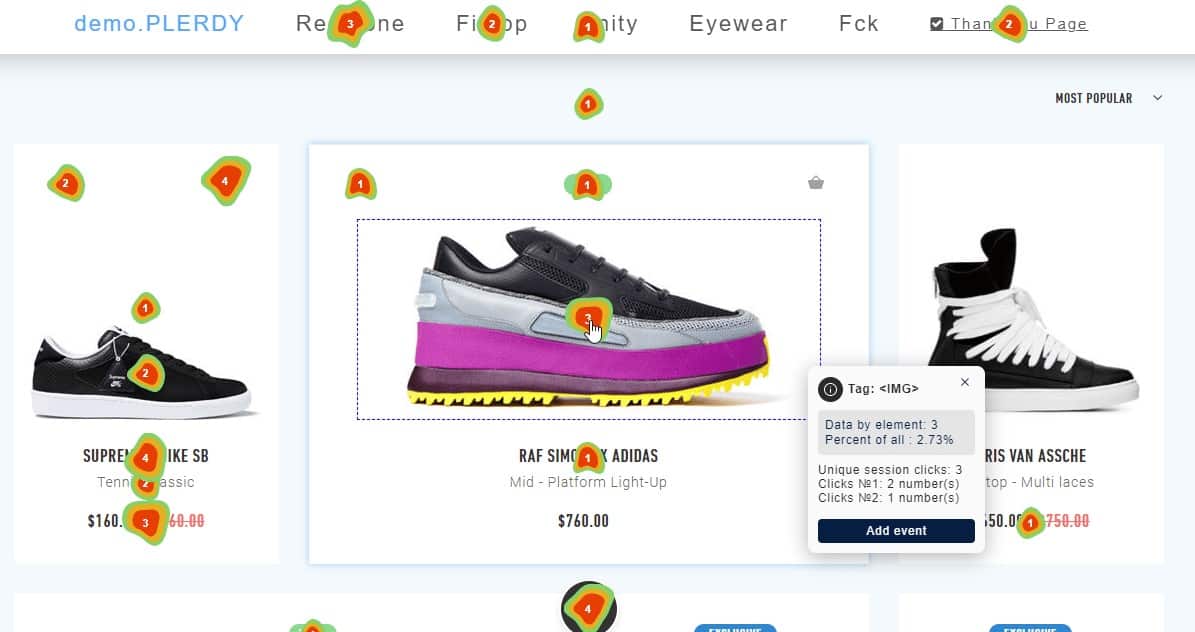

Карта кліків сайту: огляд 16 сервісів

Карта кліків сайту: огляд 16 сервісів Просування сайтів: 9 факторів

Просування сайтів: 9 факторів Розкрутка сайту в Google: 20 порад

Розкрутка сайту в Google: 20 порад Просування інтернет-магазину

Просування інтернет-магазину Просування сайту в ТОП-10 Google

Просування сайту в ТОП-10 Google Контекстна реклама сайту в Google: 27 помилок

Контекстна реклама сайту в Google: 27 помилок SEO для малого бізнесу: усі відповіді, які Ви шукаєте

SEO для малого бізнесу: усі відповіді, які Ви шукаєте Юзабіліті аудит сайту, чому це важливо?

Юзабіліті аудит сайту, чому це важливо? Просування сайту

Просування сайту Google Ads: 3 пріоритети на 2022 рік

Google Ads: 3 пріоритети на 2022 рік